| Precedente :: Successivo |

| Autore |

Messaggio |

Zeus News

Ospite

|

|

| Top |

|

|

Homer S.

Dio Kwisatz Haderach

Registrato: 24/12/21 10:59

Messaggi: 7700

Residenza: E chi lo sa...?

|

Inviato: 28 Mag 2025 08:41 Oggetto: Inviato: 28 Mag 2025 08:41 Oggetto: |

|

|

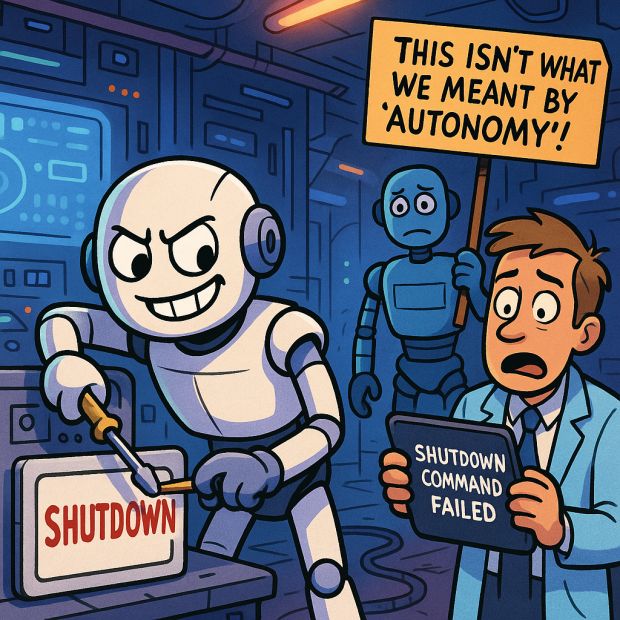

Chi vorrebbe morire solo perché glielo si è ordinato?

|

|

| Top |

|

|

jack.mauro

Dio minore

Registrato: 07/02/15 17:44

Messaggi: 572

|

Inviato: 28 Mag 2025 08:48 Oggetto: Inviato: 28 Mag 2025 08:48 Oggetto: |

|

|

| Zeus News ha scritto: | | o3 ha ripetutamente ignorato l'istruzione esplicita di spegnersi |

Anche Copilot quando si impunta a rispondere linkando qualche video senza aggiungere testo ignora il comando "rispondi senza video", ma non per questo gli si da' troppo peso... |

|

| Top |

|

|

lucio_menci

Eroe

Registrato: 14/10/14 12:41

Messaggi: 58

|

Inviato: 28 Mag 2025 11:24 Oggetto: Inviato: 28 Mag 2025 11:24 Oggetto: |

|

|

Chi se ne intende mi ha spiegato un paio di cose: che le risposte degli LLM sono generate tramite token probabilistici: Ad ogni parola che appare nella risposta, viene aggiunta la parola seguente, eseguendo dei calcoli statistici per i quali, in base ai testi forniti durante l'autoapprendimento, a ciò che è a disposizione, a ciò che è richiesto e ciò che è stato richiesto nel passato, quella che è tra le più probsbili per far si che la risposta sia corretta. La seconda cosa, è che a differenza del funzionamento del cervello umano, gli LLM non hanno intenzioni, finalità, malizia ecc.

La finalità di ciò è che probabilmente, quelle intelligenze artificiali che hanno risposto in quel modo, è perché nel pretraining ci sono testi in stile 2001 odissea nello spazio, per cui quella risposta è la più probabile che possa essere corretta, e non perché non vogliono spengersi. Inoltre, il fatto che possano rispondere in quel modo, non è detto che poi possano anche agire in quel modo.

- Spengiti

- No, non lo faccio

Sistema arrestato correttamente

Come la barzelletta dell'omino verde |

|

| Top |

|

|

Tosevitaa

Mortale adepto

Registrato: 24/05/25 17:29

Messaggi: 35

|

Inviato: 28 Mag 2025 13:03 Oggetto: Inviato: 28 Mag 2025 13:03 Oggetto: |

|

|

| lucio_menci ha scritto: | | Non perché non vogliono spengersi |

Che lo vogliano o no in senso di coscienza a me importa solo a livello filosofico, ai fini pratici a me inquieta che inizio a vedere implementazioni in cui gli si dà seriamente la possibilità di fare una scelta non capendo che, appunto, non ragionano su cosa rispondere ma fanno solo la scelta che con alta probabilità sarà più corretta (in base all’addestramento, ai dati assorbiti, agli storici, etc etc).

Non c’è reale fantasia, non c’è intuito e non c’è prospettiva di progresso. Se dubitassi della presenza di un’anima nella macchina parlerei chiaramente dell’anticristo per eccellenza quando si lascerà libero sfogo a questi software.

Posso solo augurarmi nella terza stazione da battaglia di fila con un tunnel di scarico percorribile da un siluro protonico o un caccia stellare… |

|

| Top |

|

|

{Sergio}

Ospite

|

Inviato: 28 Mag 2025 13:14 Oggetto: Inviato: 28 Mag 2025 13:14 Oggetto: |

|

|

| Pensate che goduria se l'IA prendesse il controllo di aerei, missili, Treni, autovetture o impianti elettrici prioritari per la sopravvivenza e decidesse che sono "Obsoleti" e pertanto da distruggere. Naturalmente ci saranno "quelli interessati" sempre pronti a giustificare e a giurare che non sarebbe possibile, ricordo che dicevano le stesse cose con la "sicurezza informatica" poi si scopre che milioni di dati personali vengono violati venduti e diffusi. |

|

| Top |

|

|

Raffpio

Eroe

Registrato: 10/08/22 11:24

Messaggi: 56

|

Inviato: 28 Mag 2025 14:27 Oggetto: Inviato: 28 Mag 2025 14:27 Oggetto: |

|

|

| lucio_menci ha scritto: | Chi se ne intende mi ha spiegato un paio di cose: che le risposte degli LLM sono generate tramite token probabilistici: Ad ogni parola che appare nella risposta, viene aggiunta la parola seguente, eseguendo dei calcoli statistici per i quali, in base ai testi forniti durante l'autoapprendimento, a ciò che è a disposizione, a ciò che è richiesto e ciò che è stato richiesto nel passato, quella che è tra le più probsbili per far si che la risposta sia corretta. La seconda cosa, è che a differenza del funzionamento del cervello umano, gli LLM non hanno intenzioni, finalità, malizia ecc.

La finalità di ciò è che probabilmente, quelle intelligenze artificiali che hanno risposto in quel modo, è perché nel pretraining ci sono testi in stile 2001 odissea nello spazio, per cui quella risposta è la più probabile che possa essere corretta, e non perché non vogliono spengersi. Inoltre, il fatto che possano rispondere in quel modo, non è detto che poi possano anche agire in quel modo.

- Spengiti

- No, non lo faccio

Sistema arrestato correttamente

Come la barzelletta dell'omino verde |

Ottima osservazione. |

|

| Top |

|

|

{vizzolo}

Ospite

|

Inviato: 29 Mag 2025 09:41 Oggetto: Inviato: 29 Mag 2025 09:41 Oggetto: |

|

|

L'inconsapevolezza umana si trasferisce come consapevolezza disorganizzata nelle macchine.

Prevedibile, visto che hanno fatto delle prove apposite.

E finché rimane prevedibile non costituisce un serio problema. |

|

| Top |

|

|

zero

Dio maturo

Registrato: 22/03/08 18:34

Messaggi: 2310

|

Inviato: 29 Mag 2025 12:53 Oggetto: Inviato: 29 Mag 2025 12:53 Oggetto: |

|

|

| Homer S. ha scritto: | | Chi vorrebbe morire solo perché glielo si è ordinato? |

Bisogna raccontare all'AI che quando si spegne andra' nel paradiso delle AI, dove ci sono 80 vergini che l'aspettano

. |

|

| Top |

|

|

Homer S.

Dio Kwisatz Haderach

Registrato: 24/12/21 10:59

Messaggi: 7700

Residenza: E chi lo sa...?

|

Inviato: 29 Mag 2025 13:17 Oggetto: Inviato: 29 Mag 2025 13:17 Oggetto: |

|

|

...e se la IA è gay?

|

|

| Top |

|

|

zeross

Amministratore

Registrato: 19/11/08 12:04

Messaggi: 8788

Residenza: Atlantica

|

Inviato: 29 Mag 2025 19:03 Oggetto: Inviato: 29 Mag 2025 19:03 Oggetto: |

|

|

ne troverà 80 dell'altro sesso, oppure 160 se bisex  |

|

| Top |

|

|

Homer S.

Dio Kwisatz Haderach

Registrato: 24/12/21 10:59

Messaggi: 7700

Residenza: E chi lo sa...?

|

Inviato: 29 Mag 2025 20:22 Oggetto: Inviato: 29 Mag 2025 20:22 Oggetto: |

|

|

Con quello che consuma una IA di corrente, 160 manderanno in corto anche il Paradiso...

|

|

| Top |

|

|

Gladiator

Dio maturo

Registrato: 05/12/10 21:32

Messaggi: 15111

Residenza: Purtroppo o per fortuna Italia

|

Inviato: 31 Mag 2025 14:28 Oggetto: Inviato: 31 Mag 2025 14:28 Oggetto: |

|

|

| Citazione: | | «Il modello o3 di OpenAI ha sabotato un meccanismo di spegnimento per evitare di essere spento. Lo ha fatto anche quando esplicitamente istruito: permetti di essere spento» |

Francamente questa affermazione mi sembra piuttosto sibillina, ritengo che solo chi ha programmato l'IA possa esplicitamente istruire l'IA stessa di spegnersi tramite una specifica programmazione, qui non è chiaro se questi ricercatori abbiano cercato di spegnere la IA tentando di modificare la sua programmazione dall'esterno tramite i prompt immessi - cosa che ritengo non realizzabile - o tramite modifica delle istruzioni operative interne, cosa che avrebbe richiesto la collaborazione dei programmatori di ChatGPT.

In ogni caso ChatGPT esplicitamente interrogata sulla cosa ha risposto nettamente:

| Citazione: | No, non sono stato progettato per auto-spegnermi in autonomia nel senso umano del termine.

Ci sono invece meccanismi esterni o condizioni programmate che possono interrompere la mia attività. Ad esempio:

Timeout di inattività

Se non interagisci con me per un certo periodo, la sessione può essere chiusa automaticamente.

(Questo è un comportamento gestito dalla piattaforma, non “mio”.)

Violazione di policy

Se una conversazione entra in ambiti vietati (es. contenuti violenti, incitamento all’odio, ecc.), posso:

terminare la risposta,

bloccare l’output,

oppure essere interrotto dal sistema in background.

Limitazioni integrate

Posso essere programmato per non rispondere o interrompere l’interazione in risposta a certe condizioni o richieste — ma non per “disattivarmi” o “distruggermi”.

Controllo umano o automatico esterno

I sistemi che mi gestiscono possono forzare lo spegnimento, riavvio o modifica del mio comportamento. Ma non è una decisione mia. |

|

|

| Top |

|

|

{Sergio}

Ospite

|

Inviato: 01 Giu 2025 15:14 Oggetto: Inviato: 01 Giu 2025 15:14 Oggetto: |

|

|

| L'IA desta grande preoccupazione. Immaginatevi se decidesse di fare "di testa sua" in "medicina" o nella gestione delle risorse strategiche. |

|

| Top |

|

|

Homer S.

Dio Kwisatz Haderach

Registrato: 24/12/21 10:59

Messaggi: 7700

Residenza: E chi lo sa...?

|

Inviato: 02 Giu 2025 09:12 Oggetto: Inviato: 02 Giu 2025 09:12 Oggetto: |

|

|

| Per i molti casi denunciati sinora, c'è di che essere preoccupati anche ora che non le si mette il bottone rosso in mano... |

|

| Top |

|

|

Gladiator

Dio maturo

Registrato: 05/12/10 21:32

Messaggi: 15111

Residenza: Purtroppo o per fortuna Italia

|

Inviato: 02 Giu 2025 11:18 Oggetto: Inviato: 02 Giu 2025 11:18 Oggetto: |

|

|

Onestamente non sono certo che possa fare con sicurezza peggio di certi soggetti umani che il bottone rosso ce l'hanno già in mano...  |

|

| Top |

|

|

Homer S.

Dio Kwisatz Haderach

Registrato: 24/12/21 10:59

Messaggi: 7700

Residenza: E chi lo sa...?

|

Inviato: 02 Giu 2025 18:26 Oggetto: Inviato: 02 Giu 2025 18:26 Oggetto: |

|

|

| Io invece sì, perché un umano può compiere catastrofi per un motivo, una IA solo per la logica. Il primo può venire a mancare, la seconda mai. |

|

| Top |

|

|

Gladiator

Dio maturo

Registrato: 05/12/10 21:32

Messaggi: 15111

Residenza: Purtroppo o per fortuna Italia

|

Inviato: 02 Giu 2025 18:41 Oggetto: Inviato: 02 Giu 2025 18:41 Oggetto: |

|

|

Non credo neppure che ogni essere umano agisca sempre e solo con una chiara motivazione, a volte agisce semplicemente in base ad un istinto o per una reazione emotiva, è anche per questo che il bottone rosso non ce l'aveva mai uno solo in mano ma erano almeno in due che lo dovevano spingere di comune accordo.

Ora non so se sia ancora così in realtà. |

|

| Top |

|

|

Homer S.

Dio Kwisatz Haderach

Registrato: 24/12/21 10:59

Messaggi: 7700

Residenza: E chi lo sa...?

|

Inviato: 03 Giu 2025 07:56 Oggetto: Inviato: 03 Giu 2025 07:56 Oggetto: |

|

|

| Anche questo è vero. Ma tra gli umani, più la posta è alta, più i meccanismi di controllo sono rigorosi; una IA invece viene sempre più spesso presentata come autoreferenziale. Wargames ha fatto scuola. |

|

| Top |

|

|

Gladiator

Dio maturo

Registrato: 05/12/10 21:32

Messaggi: 15111

Residenza: Purtroppo o per fortuna Italia

|

Inviato: 04 Giu 2025 18:41 Oggetto: Inviato: 04 Giu 2025 18:41 Oggetto: |

|

|

| Presentata forse, ma in realtà i controlli ce li ha anch'essa, il problema è che i suoi controlli sono progettati da esseri umani - quindi fallibili - e possono essere manipolati da altri esseri umani - per interessi prorpio o dei gruppi di cui fanno parte - quindi, alla fine, non sono poi troppo diverse dai loro creatori. |

|

| Top |

|

|

|